Das Teilprojekt B06 des SFB/TRR 318 „Constructing Explainability“ untersucht die Normativität von XAI aus ethischer und medienwissenschaftlicher Perspektive. Bisher mangelt es an einer Untersuchung der Normativität von XAI, das heißt unter anderem einer Analyse der Frage, wozu XAI eigentlich gut sein soll, denn Erklärungen sind kein Selbstzweck. Die fehlende Auseinandersetzung mit der Frage nach den Zwecken von XAI ist auf eine einseitige Problemdefinition zurückzuführen. Maßgeblich für den Forschungsbereich XAI ist es, XAI als Antwort auf das Blackbox-Problem von KI-Systemen zu konzipieren. Die fehlende Transparenz und Verstehbarkeit der Systeme (Blackbox) sei der price to pay für Genauigkeit und Effizienz. Einseitig ist diese Problemkonzeption in mindestens zwei Hinsichten: Erstens, muss die Opazität nicht per se problematisch sein, sondern es gilt genauer zu fragen für wen, wozu, in welchen Kontexten eine Erklärung der Blackbox dienlich ist oder sein sollte. Zweitens gilt es die verschiedenen Kontexte und Stakeholder in den Blick zu nehmen und zu fragen, wann für wen welche Transparenz- oder Erklärungsstrategie angemessen und relevant sein können.

Das Teilprojekt trägt zur Beantwortung dieser Fragen in spezifischer Weise bei. In der ersten Phase hat unsere Fachgruppe “Philosophie und Ethik wissenschaftlich-technischer Kulturen” zunächst die übergeneralisierte Inwertsetzung von Erklärbarkeit hinterfragt. Erklärungen sind nicht per se als positiv zu betrachten, da sie nicht immer gewollt, hilfreich oder notwendig sind. So ist es nicht notwendig, die inneren Abläufe eines Zuges zu verstehen, um effektiv zur Arbeit zu pendeln. Unangemessene Erklärungsangebote können Gesprächspartner verärgern und zu einem Interaktionsabbruch führen. Eine detaillierte Erläuterung aller Schritte und Mechanismen, die die Entscheidungsfindung einer Jury in einem Gerichtsprozess ausmacht, könnte die Autorität der Institution untergraben. Wenn XAI in realen Anwendungen hilfreich sein soll, muss sich das Forschungsfeld ernsthaft mit der Frage der Relevanz von Erklärungen auseinandersetzen und diese hinreichen kontextualisieren.

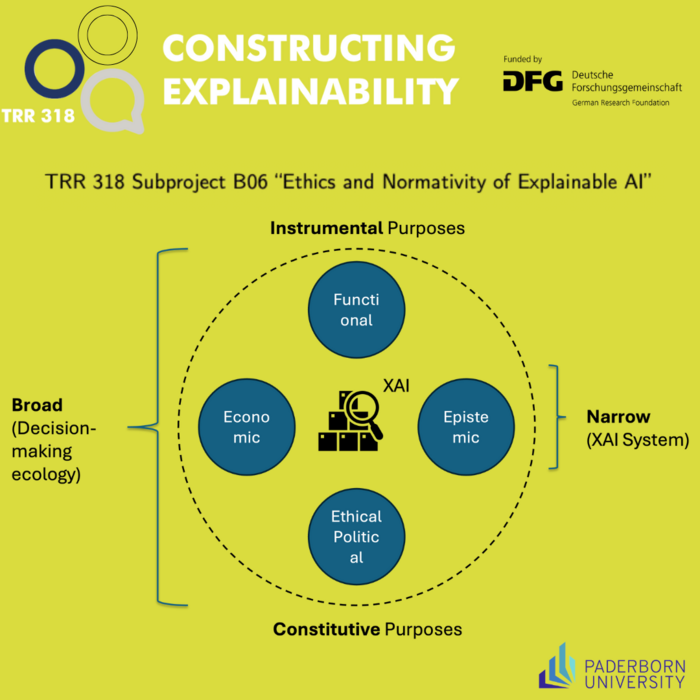

Die Wissenschaftler*innen haben hierfür den XAI-Diskurs untersucht und eine Taxonomie der typischen Zwecksetzung im Forschungsfeld erstellt. Diese lassen sich vier Hauptkategorien zuordnen:

- funktionale (z.B. Optimierung der KI-Systeme),

- ökonomische (z.B. Akzeptanz und Bedienbarkeit für die Nutzenden),

- epistemische (z.B. wissenschaftliche Erkenntnisse validieren) sowie

- ethisch-politische Zwecke (z.B. die Förderung oder Ermöglichung von Verantwortung, Autonomie).

Diese Zweckkategorien können je nach Kontext der XAI-Nutzungen von instrumenteller oder von konstitutiver Natur sein.

- Instrumenteller Art sind die Zwecke, wenn der gleiche Zweck auch mit anderen Mitteln erreicht werden kann,

- konstitutiv sind die Zwecke, wenn ihre Realisierung notwendig von Erklärungen abhängt (wenn der Zweck Selbstbestimmung oder Verantwortungsübernahme davon abhängt, die KI-Systeme hinreichend verstehen zu können).

Die Taxonomie des Projekts verdeutlicht, dass bislang die entwickelnden XAI-Techniken der Verschiedenheit der Zwecke und Kontexte ihres Einsatzes nicht gerecht werden. In Phase zwei des Projekts plant die Fachgruppe deshalb die Relevanz von Erklärungen an ausgewählten Szenarien aus dem Bereich Medizin, Bildung und Polizeiarbeit in ihrer jeweiligen Kontextabhängigkeit zu analysieren. Hierfür erweitern sie die in der Technikethik etablierte Methode des Value-Sensitive Designs um die Dimension organisationeller Kontexte.

Mehr Informationen über das Projekt gibt es hier.