Quiz game with explainable results

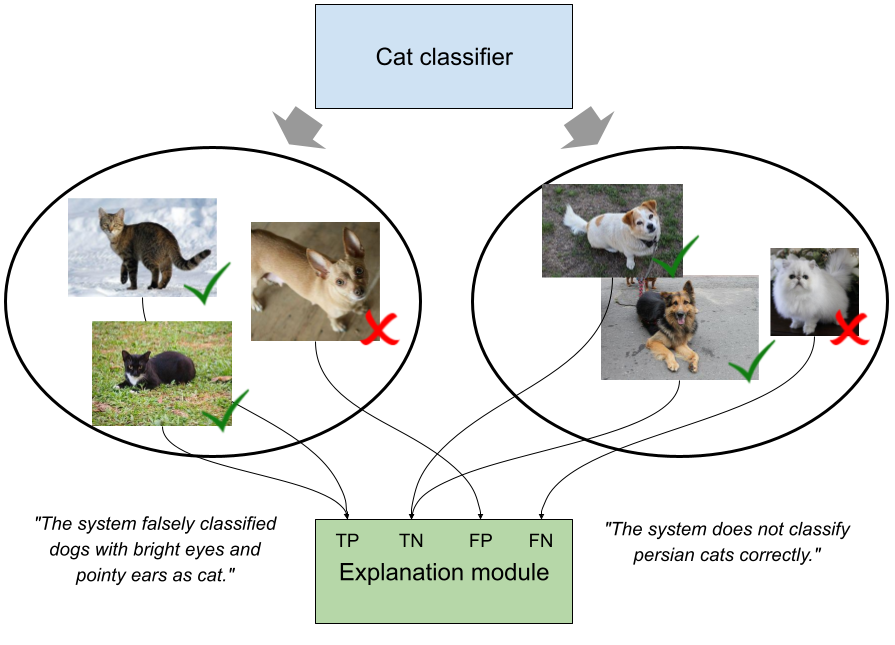

Die Evaluierung verschiedener Ansätze ist für die Datenwissenschaft von entscheidender Bedeutung. Die gesammelten Evaluierungsergebnisse können die Stärken und Schwächen verschiedener Ansätze aufzeigen und als Leitfaden für die weitere Entwicklung dienen. Vor allem, wenn eine Evaluierung dem Forscher große Mengen an Ergebnissen liefert, kann die manuelle Analyse jedoch zu einer Herausforderung werden. Eine Lösung für dieses Problem könnte ein Ansatz sein, der erklärt, in welchen Fällen ein evaluierter Ansatz erfolgreich ist und in welchen Fällen er scheitert. Die Abbildung unten zeigt dieses Konzept am Beispiel eines Klassifikators, der erkennen soll, ob ein gegebenes Bild eine Katze zeigt (linke Klasse) oder nicht (rechte Klasse).

Das Ziel von Explainable Benchmarking ist es, Erklärungen wie in der obigen Abbildung zu liefern, d.h. Erklärungen für Fälle, in denen ein evaluiertes System gut oder nicht gut abschneidet. Das Ziel dieser Arbeit ist es, einen kleinen Demonstrator bereitzustellen, der dem Publikum zeigt, was Explainable Benchmarking bedeutet. Zu diesem Zweck möchten wir es mit einem Spiel kombinieren. Der Benutzer spielt das Spiel und erhält eine Zusammenfassung seiner Leistung. Die Zusammenfassung wird dann so erstellt, als ob der Benutzer ein Ansatz wäre, für den wir Erklärungen erhalten möchten.

Das Spiel soll ein Quiz sein. Die Fragen für das Quiz sollten auf der Grundlage einer Wissensbasis (z.B. DBpedia oder Wikidata) generiert werden. Ähnlich wie bei früheren Ansätzen wie ASSESS oder Clover Quiz, generieren wir Multiple-Choice-Fragen, indem wir Aussagen aus der Wissensbasis verwenden. Die ausgewählten Aussagen (s,p,o) stellen die richtige Antwort dar. Wir generieren falsche Antworten (s,p,o'), indem wir o' mit einer hohen Ähnlichkeit zu o auswählen. Die Ähnlichkeit kann mit einem Modell zur Einbettung von Wissensgraphen gemessen werden. Auf der Grundlage der richtig und falsch beantworteten Fragen können wir Erklärungen für das Ergebnis des Spielers mit Hilfe des Lernens von Klassenausdrücken generieren (z.B. mit Ontolearn).

Das endgültige Ziel ist es, die fertige Arbeit bei der Demo-Session einer Konferenz einzureichen (nach Fertigstellung der Diplomarbeit) und es einfacher zu machen, das Konzept des erklärbaren Benchmarking den Leuten zu erklären.